Gli sviluppi dell’intelligenza artificiale generativa procedono velocissimi.

Quelli dei sistemi e delle regolamentazioni che dovrebbero ridurre e punire gli usi malevoli dell’AI (e mettere i cittadini nelle condizioni di sapere quando si trovano di fronte contenuti creati o manipolati artificialmente) vanno invece molto più lentamente.

Il casino di Open AI

Questa discrepanza emerge chiaramente dal casino successo dentro Open AI, oggi la più famosa società di intelligenza artificiale. Il lancio di una nuova impressionante evoluzione del modello di IA della startup (GPT-4o) è stato seguito dall’ammutinamento dei leader del team incaricato di assicurarsi che l’AI non distrugga l’umanità. Dopo nemmeno un paio di giorni, la startup ha dovuto fare i conti con l’accusa dell’attrice Scarlett Johansson che una delle voci sintetiche di ChatGPT (il chatbot di Open AI) è stata realizzata clonando la sua voce.

Il furto di voci

Poco importa, in questo discorso, se Open AI abbia davvero clonato la voce di Johansson (pare di no). È comunque certo che le clonazioni non autorizzate di voci avvengono già.

Un caso recente piuttosto eclatante è stato quello dei doppiatori Paul Lehrman e Linnea Sage, che hanno scoperto per caso che una nota società di AI con cui avevano avuto contatti – Lovo – aveva creato delle versioni sintetiche delle loro voci e le aveva messe in vendita senza il loro consenso.

💸 I doppiatori hanno chiesto a Lovo un risarcimento di 5 milioni di dollari.

La valanga dei deepfake audio

Rimanendo in ambito audio, quello di cui si occupa questa newsletter, oltre alla clonazione illecita di voci per scopi commerciali c’è poi tutta la questione dei deepfake audio, ossia voci sintetiche che impersonano determinate persone con scopi malevoli (per esempio per manipolare il risultato delle elezioni, come racconta bene questo report: è successo negli Stati Uniti e in India, solo per citare due Paesi di un certo peso).

Gli strumenti per creare i deepfake audio, tra cui spiccano quelli di Eleven Labs o di Wondercraft, hanno ormai raggiunto livelli raffinatissimi, e con il fatto che sono accessibili a chiunque si capisce come mai la quantità di deepfake in giro sia sempre di più.

Tanto che, come sottolineano shirin anlen e Raquel Vázquez Llorente in un interessante pezzo per il Reuters Institute,

«la più grande minaccia causata dall’IA generativa in campo audiovisivo è che ha aperto la possibilità della plausible deniability (negabilità plausibile), con la quale si può affermare che qualsiasi cosa è un deepfake».

L’inghippo della trasparenza

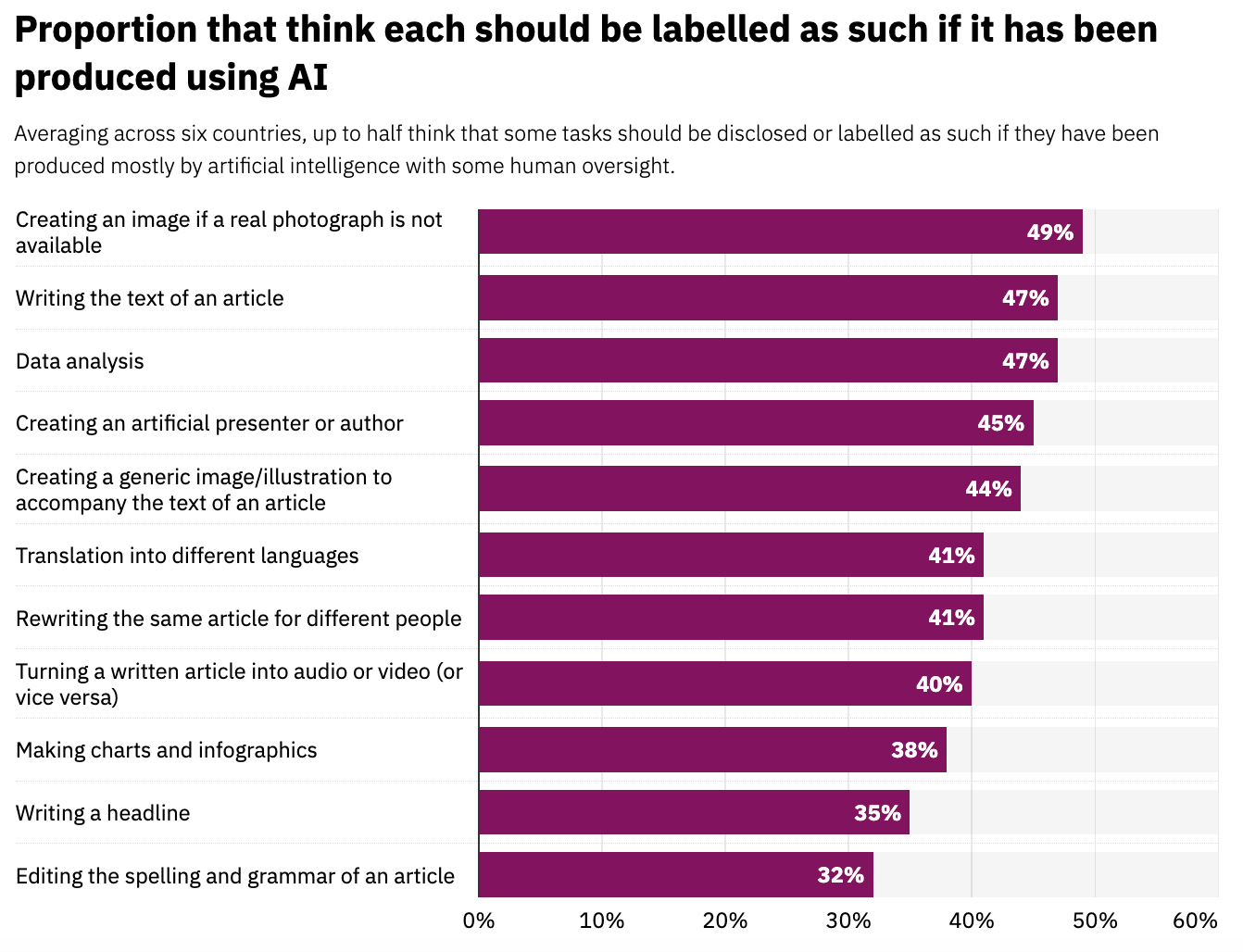

Si pone poi il problema delle scarse o nulle opportunità per i cittadini di sapere se stanno ascoltando un contenuto fatto con l’AI, anche nel caso di contenuti con tutte le carte in regola. Nonostante la maggioranza delle persone che hanno risposto a un sondaggio condotto da YouGov per il Reuters Institute pensi che non sia necessario etichettare i contenuti realizzati con l’AI come tali, è comunque importante che ci sia la possibilità di sapere quando c’è stato un intervento di qualche tipo di intelligenza artificiale.

Gli attori coinvolti nell’audio safety

Come si stanno comportando le società che sviluppano tecnologie di intelligenza artificiale e le società tech in generale, le piattaforme, i media, i politici e i regolamentatori e gli stessi cittadini rispetto a questo gigantesco calderone che ha a che fare con l’audio safety?

💡 Questo pezzo mette in fila vari rischi rappresentati dall’applicazione dell’AI in ambito audio.

Per capirlo ho sentito alcune persone che si occupano in modi diversi di intelligenza artificiale in ambito audio.

- Alexios Mantzarlis, autore della newsletter sulla disinformazione digitale Faked Up e direttore del Security, Trust and Safety Initiative al Cornell Tech di New York

- Andrea Ballista e Lorenzo Tarantino, cofondatori e rispettivamente ceo e cto di Voiseed, startup italiana che fa voci sintetiche espressive

- Olalla Novoa, coordinatrice dei progetti di Prisa Media legati alla voce tra cui VerificAudio, strumento che aiuta i giornalisti a identificare audio deepfake in spagnolo

Partiamo con l’intervista ad Alexios Mantzarlis.

L’intervista ad Alexios Mantzarlis

Ormai è molto facile creare o manipolare contenuti audio attraverso l’AI, con risultati impressionanti. Per l’orecchio umano, riconoscere che un determinato contenuto audio è stato modificato o creato con l’intelligenza artificiale è diventato quasi impossibile. Che pensi?

«Da una parte, dopo uno shock iniziale, la società si adegua agli strumenti che manipolano la realtà come Photoshop o i filtri del cellulare. D’altro canto, questi strumenti si sono spesso concentrati sulle immagini. La manipolazione di massa dell’audio potrebbe avere un impatto maggiore nel breve termine perché aggredisce un formato comunicativo in cui c’è relativa fiducia».

Quali rischi corrono i cittadini? In che modo possono tutelarsi?

«In questo momento il rischio principale è monetario. Attraverso delle note vocali che impersonavano colleghi o parenti, alcune vittime sono state spinte a fare investimenti o trasferimenti finanziari che si sono rivelati fraudolenti. Temo che questo fenomeno crescerà ulteriormente.

L’IA è stata inoltre usata per scopi di disinformazione politica un po’ in tutto il mondo, dalla Slovacchia al Canada e dagli USA all’India. Principalmente, si è trattato di imitazioni molto credibili delle voci di figure politiche disseminate con lo scopo di dissuadere gli elettori dal voto.

La cosa sicuramente più inquietante è quando l’audio manipolato diventa interattivo, aumentando drammaticamente la capacità di persuadere. Una cosa è ricevere una nota vocale, un’altra è avere una vera e propria conversazione con uno strumento di IA che imita la voce di qualcuno che conosciamo.

Per proteggersi, i cittadini dovranno sempre più fare delle valutazioni non solo sulla credibilità del messaggio che hanno ricevuto ma anche del mezzo e del messaggero. Chi ha condiviso l’audio in questione? Tramite che strumento? Cosa è successo prima e dopo che ci può permettere di verificare quello che ci è stato detto? Più un messaggio sarà sorprendente e più dovremo porci domande sul contesto in cui è stato ricevuto».

In questo contesto, quale pensi che dovrebbe essere il ruolo dei media?

«Sicuramente i giornalisti devono essere molto vigili ed evitare di disseminare audio falsificati. Ancora meglio se riescono a svolgere un ruolo attivo nell’informare il pubblico sugli audio manipolati che circolano e rischiano di causare un danno economico o socio-politico. Ma il ruolo principale qui è delle piattaforme che permettono la creazione dell’audio sintetico, delle istituzioni che le regolamentano, e dei cittadini».

💡 Intanto il Consiglio europeo ha approvato definitivamente il cosiddetto AI Act (che prevede, tra le altre cose, che i contenuti generati o modificati con l’AI debbano essere etichettati come tali). C’è anche da dire che era dal 2021 che se ne discuteva, e che nel resto del mondo comunque di regolamenti o leggi del genere ancora non ne esistono.

E le aziende di AI come dovrebbero comportarsi?

«Sicuramente devono investire nel watermarking e in altri contrassegni che viaggiano coi contenuti creati con l’IA. Purtroppo, questo non basterà. Serviranno anche controlli assidui sul tipo di contenuti che vengono creati dai loro utenti. E le aziende dovranno rendere disponibili al pubblico metodi semplici e trasparenti per verificare se un audio è stato fabbricato attraverso i loro strumenti. Come società dovremo anche essere consapevoli che questi metodi non potranno essere infallibili, e dovremo quindi abituarci a gestire contenuti la cui provenienza è incerta».

C’è qualche caso studio interessante che vorresti segnalare?

«Ho trovato questoarticolo sull’utilizzo delle note vocali da parte di un crypto-scammer australiano che dimostra chiaramente come questa tecnologia venga abusata. E seguirò con interesse l’avvento di tecnologie che permettono a ciascuno di noi di creare un modello IA della propria voce per rispondere a telefonate non sollecitate o eseguire altri compiti che non amiamo. Temo che ciò che oggi appare comodo domani si rivelerà rischioso».

💌 Se questi temi ti interessano ti consiglio di iscriverti a Faked Up, la newsletter di Alexios Mantzarlis sulla disinformazione digitale.

***

Se ti interessa approfondire i principali aspetti legati ai rischi di un utilizzo non etico dell’intelligenza artificiale generativa in ambito audio ti consigliamo anche:

Leave a Reply