La parola “Fabriano” mi fa viaggiare alle scuole medie e agli album da disegno per educazione tecnica. Penso a Fabriano (che, oltre a essere una storica azienda cartiera, è anche la città marchigiana dove l’azienda è nata) e subito mi viene in mente la carta. Anche se nessuno sa bene come la carta arrivò fino a lì: probabilmente ce la portarono gli arabi.

Un’invenzione italiana

In ogni caso, i fabrianesi sono considerati maestri a livello mondiale nella produzione della carta. Già nel XIII secolo si erano posti il problema di come certificare l’unicità delle loro carte. Lo spunto glielo diederono le marche dei lanaioli. Così si misero a intrecciare «segni e disegni tra le vergelle e le catenelle dei propri telai», invisibili segni d’acqua illuminati solo in controluce.

Era nata la filigrana, watermarking in inglese. A Fabriano, un ex convento dei frati domenicani ospita il museo dedicato alla tradizione delle carte e delle filigrane locali.

Per secoli la filigrana è stata usata proprio per certificare l’autenticità di testi e immagini, impedire la contraffazione di banconote e documenti e poi, soprattutto con l’avvento di Internet, anche per provare a evitare l’uso non autorizzato di contenuti vari. Infine, in questa nostra epoca dell’intelligenza artificiale la filigrana è diventata uno strumento, più o meno efficace, per segnalare che un determinato contenuto è stato generato con l’AI.

Filigrane contro deepfake audio

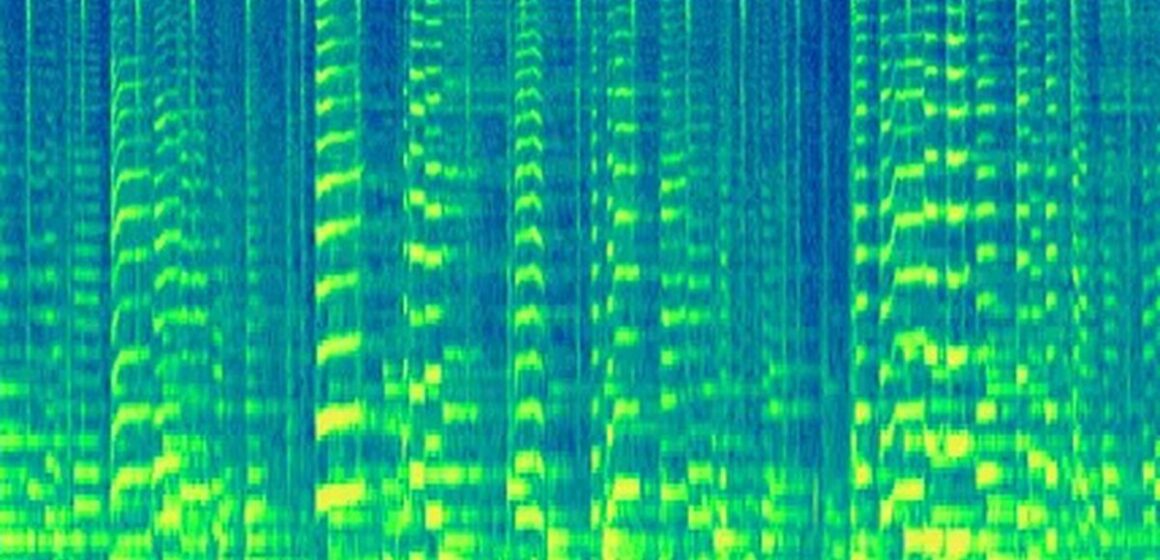

Scrivo qui di filigrane perché la soluzione del watermarking è sempre più diffusa anche in ambito audio. Alcuni sono convinti per esempio che il watermarking possa essere uno strumento efficace per identificare i deepfake audio. (Come vedremo altri sono invece scettici, anche per la mancanza di standard, e altri ancora ne temono usi impropri.)

Anche la più famosa società di AI al mondo, OpenAI, ha previsto l’integrazione di un watermarking per gli audio generati con VoiceEngine, il suo portentoso strumento di clonazione vocale (così portentoso, e quindi potenzialmente pericoloso, da averne ritardato il rilascio pubblico per motivi di sicurezza).

Meta, la società dietro Instagram, Facebook e Whatsapp, di recente ha rilasciato pubblicamente uno strumento di watermarking audio molto innovativo, AudioSeal: «il primo in grado di individuare quali bit di audio, ad esempio in un podcast di un’ora intera, potrebbero essere stati generati dall’intelligenza artificiale».

💡 Per chi fosse interessato alla questione, consiglio questo paper.

Al di là di quello che stanno facendo colossi come OpenAI e Meta, mi interessava capire come si stanno muovendo sul fronte della sicurezza e dell’etica le aziende di clonazione vocale più piccole. Negli ultimi anni ne sono nate moltissime; alcune sono già fallite.

Voicing the unvoiced

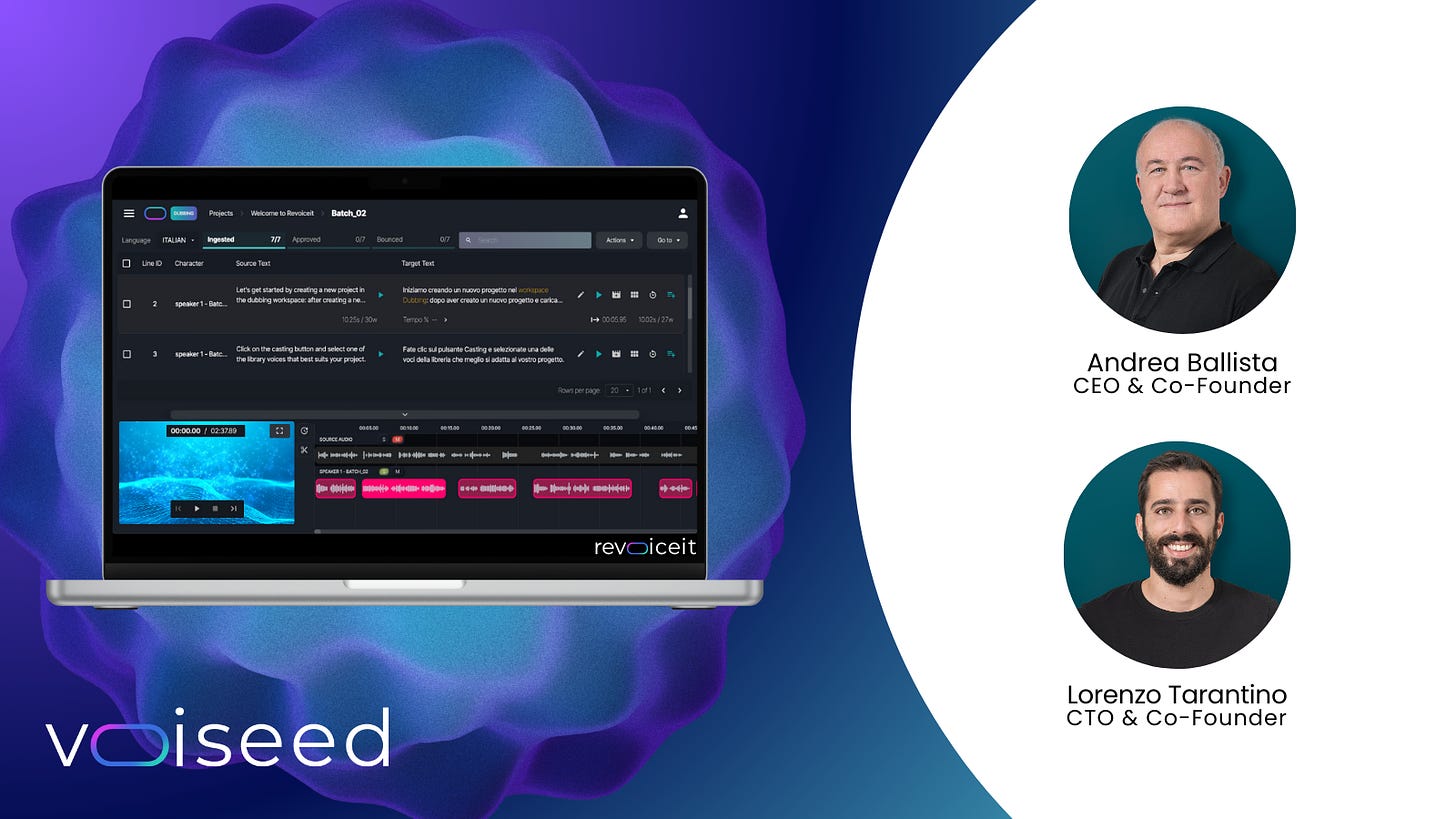

Tra le molte realtà esistenti c’è Voiseed, startup milanese con una forza lavoro di 15 persone specializzata nella generazione di voci sintetiche espressive nell’ambito del doppiaggio. Uno dei motti dell’azienda è Voicing the unvoiced: si occupa di doppiare tutti quei contenuti che prima di solito non venivano doppiati, banalmente perché non c’erano e non ci sono abbastanza professionisti per doppiare l’enorme massa di contenuti esistenti.

A differenza della stragrande maggioranza delle società che fanno clonazione vocale, Voiseed lavora B2B. Significa che i suoi clienti non sono i consumatori finali, ma le aziende. Tra queste c’è Chora: è stata proprio Voiseed a clonare la voce di Guido Maria Brera per creare la versione in inglese del podcast Black Box (attraverso cui ho scoperto l’esistenza della startup).

«Noi non offriamo soltanto la tecnologia. Offriamo anche una piattaforma che emula il processo di doppiaggio, però attraverso le voci artificiali», mi ha spiegato Lorenzo Tarantino, ingegnere informatico esperto di generazione di voci espressive. «La nostra piattaforma non è pensata per essere automatica, ma richiede l’interazione di un curatore umano», ha aggiunto Andrea Ballista, da 30 anni nel mondo della localizzazione audio (soprattutto nel gaming). «La piattaforma propone una soluzione al curatore, che è una persona con competenze linguistiche, e il curatore valuta se la pronuncia delle frasi va bene o meno».

Gli accordi con gli attori

Ballista e Tarantino sono le persone che, nel 2020, hanno dato vita a Voiseed. Nel 2021 la loro creatura ha ricevuto una spinta importante grazie al programma Horizon Europe e a un finanziamento da parte dell’EIC (European Innovation Council). È uno dei bandi per startup più competitivi a livello europeo. Voiseed è stata selezionata tra oltre 1000 aziende partecipanti, ed è stata una delle due uniche aziende italiane selezionate in quel round.

«Il fatto che il nostro progetto sia stato finanziato da Horizon Europe ci ha spinto ulteriormente ad avere come faro l’aspetto etico», mi ha detto Ballista. «Per esempio, a differenza delle altre startup, noi non abbiamo mai diffuso in rete la nostra tecnologia di clonazione vocale».

Ballista mi ha spiegato che la policy di Voiseed prevede anche che l’attore, il doppiatore o comunque chi mette la voce deve sempre dare il consenso e ricevere un compenso adeguato: «Nel momento in cui un cliente dice “voglio clonare la voce di una persona” chiediamo espressamente alla società di fornirci l’accordo con quella persona, una liberatoria insomma. Abbiamo visto tutti che cos’è successo a OpenAI con Scarlett Johansson (riassumo: l’attrice ha accusato OpenAI di avere clonato la sua voce senza consenso, anche se OpenAI ha smentito). E poi c’è stato il caso di Lovo (la startup ha subito un’azione legale per avere clonato senza permesso le voci di due doppiatori). Noi siamo sempre stati molto attenti su questo discorso. Certo, gli errori possono capitare. Ma è innanzitutto l’intento malizioso che va ucciso. E noi lo abbiamo ucciso».

AAA standard cercansi

Un’altra questione è quella della trasparenza sull’origine artificiale degli audio prodotti con gli strumenti della startup. «Intanto possiamo dire che, dal momento che lavoriamo con aziende, sappiamo chi e come usa la nostra tecnologia. Di sicuro non viene usata per fare truffe telefoniche», spiega Tarantino.

💡 Leggi anche Kit di sopravvivenza per ascoltatori nell’era dell’AI

Al momento però Voiseed non ha ancora implementato un sistema di watermarking, anche se ci sta lavorando. «La complessità sta nel creare un audio che non degradi e nel far sì che l’informazione sia facilmente intercettata dagli algoritmi. Peraltro al momento non esistono standard per il watermarking, ossia per identificare se un audio è stato generato artificialmente. È un punto su cui la comunità di ricerca e sviluppo nel mondo speech dovrebbe concentrarsi per definire regole condivise, anche per risalire all’origine dei dati e tracciare la filiera della generazione dei contenuti digitali».

E c’è il fatto che il watermarking permette solo ai software di capire che l’audio è stato generato artificialmente, non agli utenti. «L’unico modo per avvisare chi ascolta che sta ascoltando un contenuto sintetico è farlo dire alla voce stessa. Cosa che chiediamo come prerequisito alle aziende con cui lavoriamo, anche se non possiamo imporlo», osserva Ballista.

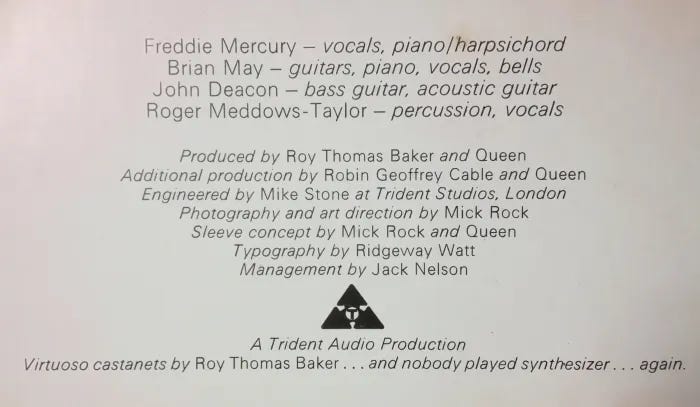

«È come le etichette di provenienza. O come quando i Queen nei loro album scrivevano “no synthesizers”, per esplicitare che le canzoni non erano state fatte con l’uso di sintetizzatori. Noi allo stesso modo chiediamo di dichirare che il contenuto è stato prodotto con la tecnologia di intelligenza artificiale di Voiseed, com’è previsto anche dall’AI Act».

* * *

Piccolo prontuario per orientarsi nel mondo dell’AI Audio

–Localizzazione: il processo che serve per rendere fruibile un contenuto audiovisivo ai parlanti di lingue diverse da quella di origine, anche attraverso un lavoro di adattamento culturale.

Comprende varie fasi: la trascrizione, la traduzione, l’adattamento della traduzione e infine il doppiaggio nella lingua target (Voiseed si occupa di quest’ultima fase, il doppiaggio).

–Trascrizione audio-testo: è appunto la trascrizione, tramite specifiche tecnologie, di ciò che viene detto in un audio.

–Generazione vocale sintetizzata: la creazione di un file audio attraverso l’utilizzo di modelli di AI generativa. Il testo e i segnali che gli algoritmi captano rispetto ad emissione e prosodia nell’audio sorgente sono il “prompt” (ossia un’istruzione o indicazione) per la generazione di un audio sintetizzato target.

Per riassumere, l’audio viene generato partendo da tre tipi di input:

1. testuale => testo sorgente + traduzione nelle varie lingue;

2. prosodico => rilevamento emozione ed emissione dell’audio sorgente/durata delle parole/intonazione;

3. voce => voci completamente sintetizzate generate, nel caso di Voiseed, da algoritmi proprietari in via di brevetto.

Da dove arrivano i dati?

I dati utilizzati da Voiseed per l’addestramento sono raccolti attraverso partnership con svariati studi di registrazione internazionali situati in più di 16 Paesi.

Vengono usati copioni con frasi in grado di mappare le principali espressioni/emozioni ed emissioni (dalla felicità alla tristezza, dal sussurrato all’urlato), tradotti e registrati in diverse lingue. Il dato fondamentale non è il testo, ma proprio l’interpretazione. E i file audio delle performance sono la base per insegnare ai modelli come riprodurre una certa emozione in una determinata lingua.

In accordo con gli studi di registrazione, da questi dati non sono estrapolate le voci, ma servono solo ad addestrare i modelli al riconoscimento delle emozioni/emissioni.

***

Se ti interessa approfondire i principali aspetti legati ai rischi di un utilizzo non etico dell’intelligenza artificiale generativa in ambito audio ti consigliamo anche:

Leave a Reply